Die Datenanalyse (engl. Data Analytics) ist die Wissenschaft und Technik der systematischen Untersuchung von Datenbeständen, um verborgene Muster, Korrelationen, Trends und andere wertvolle Erkenntnisse zu identifizieren. In einer global vernetzten Wirtschaft bildet sie das Rückgrat der evidenzbasierten Entscheidungsfindung.

Während die klassische Statistik oft auf Stichproben beruhte, ermöglicht die moderne Datenanalyse heute die Verarbeitung massiver, unstrukturierter Datenmengen (Big Data) in Echtzeit. Dabei geht es nicht mehr nur um die reine Deskription der Vergangenheit, sondern zunehmend um die proaktive Gestaltung der Zukunft durch Algorithmen und künstliche Intelligenz.

Grafik: Generiert mit KI

Datenanalyse: Die Evolution der Analysemethodik

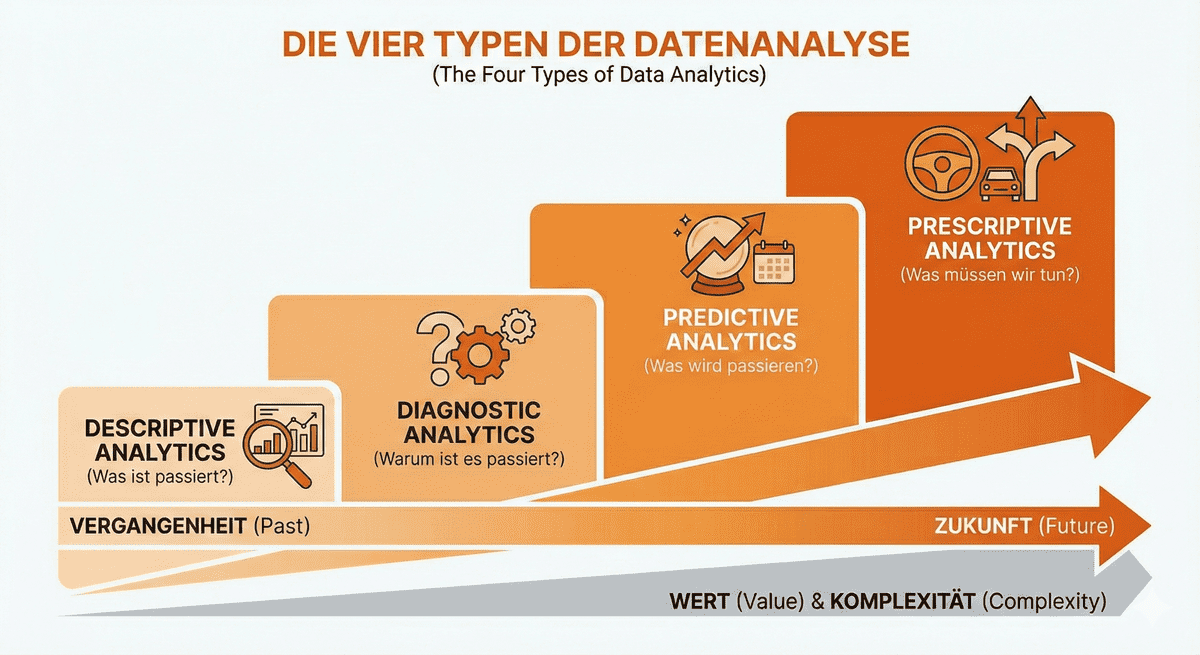

Um die Tiefe der Datenanalyse zu verstehen, ist eine Differenzierung nach der Komplexität und dem angestrebten Erkenntnisgewinn notwendig. Die moderne Wissenschaft unterscheidet hierbei vier wesentliche Reifegrade:

Deskriptive Analsye

Die Deskriptive Analyse bildet das Fundament. Sie beantwortet die Frage, was in einem bestimmten Zeitraum geschehen ist. Hierbei werden Rohdaten aggregiert und visualisiert, etwa in Form von Kennzahlen (KPIs) oder Dashboards. Sie dient der Transparenz, liefert jedoch noch keine Erklärungen für Ursachen.

Diagnostische Analyse, Data Mining, Drill-Down-Verfahren

Auf der Deskriptiven Analyse baut die Diagnostische Analyse auf. Ihr Ziel ist die Identifikation von Kausalitäten. Durch Techniken wie Data Mining oder Drill-Down-Verfahren wird untersucht, warum bestimmte Ereignisse eingetreten sind. Dies ist entscheidend, um Fehlentwicklungen zu korrigieren oder Erfolgsfaktoren zu isolieren.

Das Data Mining bezeichnet die automatisierte Suche nach verborgenen Mustern, Trends oder komplexen Querverbindungen innerhalb großer Datenbestände (Big Data). Hierbei kommen mathematische Algorithmen und statistische Methoden zum Einsatz, um Anomalien zu identifizieren oder Datenpunkte mit ähnlichen Merkmalen in Gruppen zusammenzufassen (Clustering). In der Logistik lassen sich so oft nicht offensichtliche Zusammenhänge aufdecken – etwa die Erkenntnis, dass Lieferverzögerungen gehäuft auftreten, wenn spezifische Wetterlagen mit bestimmten Schichtmodellen im Umschlaglager zusammentreffen.

Das Drill-Down-Verfahren hingegen dient der schrittweisen Detaillierung von bereits vorhandenen Informationen. Man bewegt sich dabei von einer aggregierten Übersicht, wie zum Beispiel einem monatlichen Kostenbericht, tiefer in die granulare Datenebene, um die genauen Ursachen für eine Entwicklung zu isolieren. In modernen Dashboards funktioniert dies wie eine digitale Zoom-Funktion, die eine Kennzahl bis auf den einzelnen Geschäftsvorfall zurückverfolgbar macht. Ein typisches Beispiel für diesen Analysepfad in der Transportlogistik wäre:

- Ebene 1: Ein Klick auf den Monat „Juni“ zeigt die Kostenverteilung nach Regionen.

- Ebene 2: Ein Klick auf die „Region Nord“ isoliert die Kosten pro eingesetztem Fahrzeugtyp.

- Ebene 3: Ein Klick auf den „Sattelzug“ legt die detaillierten Einzelbuchungen, wie Tankbelege oder spezifische Werkstattrechnungen, offen.

Prädiktive Analyse

Die Prädiktive Analyse markiert den Übergang zur fortgeschrittenen Datenwissenschaft. Unter Einsatz statistischer Modelle und Machine-Learning-Algorithmen werden Prognosen über zukünftige Ereignisse erstellt. Die Qualität dieser Vorhersagen hängt maßgeblich von der historischen Datenbasis und der Modellvalidierung ab.

Präskriptive Analyse

Die höchste bzw. komplexeste Stufe ist die Präskriptive Analyse. Sie beschränkt sich nicht auf Vorhersagen, sondern simuliert verschiedene Szenarien und empfiehlt konkrete Handlungsoptionen, um ein definiertes Ziel (z. B. Gewinnmaximierung oder Risikominimierung) zu erreichen. Sie automatisiert oft Teile des Entscheidungsprozesses.

Datenanalyse: der analytische Lebenszyklus

Ein professioneller Analyseprozess folgt einer strukturierten Methodik, die weit über das bloße Rechnen hinausgeht. Zu Beginn steht die präzise Definition der Fragestellung. Ohne ein klares Geschäftsziel oder eine wissenschaftliche Hypothese verliert sich die Analyse in irrelevanten Datenmustern.

Es folgt die Datengewinnung und -aufbereitung, der oft zeitaufwendigste Teil. Hierbei müssen Daten aus disparaten Quellen (ERP-Systeme, Sensoren, externe Datenbanken) extrahiert, bereinigt und harmonisiert werden. Fehlende Werte oder Ausreißer können die Ergebnisse massiv verfälschen, weshalb die Datenqualitätssicherung hier oberste Priorität hat.

In der Modellierungs- und Analysephase kommen mathematische Verfahren zum Einsatz. Hier entscheidet sich, ob lineare Regressionen, Entscheidungsbäume oder neuronale Netze das geeignetste Werkzeug sind.

Den Abschluss bildet die Interpretation und Kommunikation. Die gewonnenen Erkenntnisse müssen so aufbereitet werden, dass sie für Entscheidungsträger verständlich sind – meist durch Storytelling mit Daten und interaktive Visualisierungen.

Strukturierte Daten – Welt der definierten Ordnung

Strukturierte Daten stellen die klassische Form der Information dar, die den meisten Menschen aus dem Geschäftsalltag bekannt ist. Diese Daten folgen einem fest vordefinierten Datenmodell oder Schema: Jedes einzelne Informationselement hat einen fest zugewiesenen Platz und einen eindeutigen Datentyp. Diese Daten sind wie Einträge in einem Karteikartensystem oder einer Tabellenkalkulation

Beispiele für Strukturierte Daten aus der Logistik

In der Transportlogistik und im Warehouse Management begegnen uns strukturierte Daten ständig. Typische Beispiele sind Artikelnummern im Lagerverwaltungssystem, exakte Zeitstempel von Beladungsvorgängen, Postleitzahlen von Empfängern oder die exakten Gewichtsangaben einer Fracht. Auch die über GPS-Tracker gelieferten Koordinaten eines Lkw zählen zu dieser Kategorie, da sie aus klar definierten Zahlenwerten bestehen.

Der große Vorteil strukturierter Daten liegt in ihrer einfachen Verarbeitbarkeit. Da sie meist in relationalen Datenbanken mittels der Abfragesprache SQL verwaltet werden, können Algorithmen sie extrem schnell durchsuchen, sortieren und mathematisch verknüpfen. Sie sind daher ideal für das klassische Berichtswesen, die Bestandsüberwachung oder die Berechnung von Durchlaufzeiten geeignet. Da die Struktur von vornherein feststeht, ist der Rechenaufwand für ihre Analyse vergleichsweise gering.

Unstrukturierte Daten – verborgen und komplex

Im Gegensatz zu strukturierten Daten besitzen unstrukturierte Daten kein vordefiniertes Format. Sie machen heute den weitaus größten Teil des weltweit produzierten Datenvolumens aus, oft wird von bis zu 80 Prozent der verfügbaren Informationen gesprochen. Diese Daten lassen sich nicht ohne Weiteres in das starre Raster von Zeilen und Spalten pressen, da ihr Inhalt variabel, vielschichtig und oft multimedial ist.

Für ein Logistikunternehmen finden sich unstrukturierte Daten beispielsweise in den Freitextfeldern von Kunden-E-Mails, in handschriftlichen Notizen auf Frachtbriefen, in Sprachaufnahmen von Fahrern oder in den Videodaten von Überwachungskameras in der Umschlagshalle. Auch Fotos, die zur Dokumentation von Ladungsschäden aufgenommen werden, sind rein unstrukturierte Informationen.

Die Arbeit mit diesen Daten erfordert deutlich fortschrittlichere Technologien als die bloße Tabellenkalkulation. Um aus einer E-Mail oder einem Schadensfoto verwertbare Erkenntnisse zu gewinnen, kommen Verfahren der Künstlichen Intelligenz zum Einsatz. Mit Natural Language Processing (NLP) lassen sich Texte verstehen und kategorisieren, während Computer Vision genutzt wird, um auf Bildern automatisch Muster oder Defekte zu erkennen.

Unstrukturierte Daten werden oft zunächst in sogenannten Data Lakes gesammelt, da man zum Zeitpunkt der Speicherung noch nicht genau wissen muss, wie man sie später strukturieren wird. Ihr immenser Nutzen liegt im „Kontext“: Während strukturierte Daten aufzeigen, dass eine Sendung beschädigt ist, liefern unstrukturierte Daten oft die Erklärung für die Ursache.

Methodische Verknüpfung strukturierter und unstrukturierter Daten in der Logistikpraxis

Die volle Leistungsfähigkeit der Datenanalyse entfaltet sich erst dann, wenn beide Datenwelten miteinander verknüpft werden. In einem modernen Warehouse Management System (WMS) führt die isolierte Betrachtung von Bestandszahlen (strukturiert) oft nur zu einem lückenhaften Bild. Erst wenn diese Zahlen mit unstrukturierten Informationen – etwa Wetterwarnungen für die Lieferroute oder Kundenfeedback zur Verpackungsqualität – kombiniert werden, entsteht eine ganzheitliche Entscheidungsgrundlage.

Ein praxisnahes Beispiel ist die prädiktive Wartung in der Transportlogistik. Strukturierte Daten liefern die Kilometerstände und die Zeit seit der letzten Inspektion. Unstrukturierte Daten, wie die akustischen Signale eines Motors oder die Vibrationsmuster während der Fahrt, werden von KI-Systemen analysiert, um kleinste Anomalien zu finden, die auf einen drohenden Defekt hinweisen. So wird aus der Kombination beider Formate eine präzise Handlungsempfehlung generiert, die teure Ausfallzeiten verhindert.

Datenanalyse in der Transportlogistik

In der Transportlogistik transformiert die Datenanalyse die Art und Weise, wie Güter physisch bewegt werden. Ein zentrales Anwendungsfeld ist die dynamische Tourenoptimierung. Anstatt statische Routen zu befahren, berechnen Systeme unter Einbeziehung von Echtzeit-Verkehrsdaten, Wetterbedingungen und Zeitfenstern der Empfänger die effizienteste Strecke. Dies führt nicht nur zu einer Reduktion der Treibstoffkosten, sondern verbessert auch die Liefertreue signifikant.

Ein weiterer entscheidender Faktor ist das Flottenmanagement durch Telematik. Sensoren an Fahrzeugen liefern kontinuierlich Daten über den Zustand von Motor, Reifen und Bremsen. Die prädiktive Wartung (Predictive Maintenance) analysiert diese Daten, um Verschleißerscheinungen zu erkennen, bevor ein Defekt auftritt. Dies minimiert ungeplante Stillstandzeiten und verlängert die Lebensdauer des Fuhrparks. Zudem ermöglicht die Analyse von Fahrverhaltensdaten (Beschleunigung, Bremsmanöver) gezielte Schulungen zur Steigerung der Sicherheit und Kraftstoffeffizienz.

Im Bereich der Supply Chain Visibility ermöglicht die Datenanalyse eine lückenlose Verfolgung der Warenströme. Durch die Verknüpfung von GPS-Daten mit Prognosemodellen können Unternehmen sehr genau berechnen, wann eine Sendung eintrifft (Estimated Time of Arrival, ETA). Bei drohenden Verzögerungen erlaubt die präskriptive Analyse die automatische Einleitung von Gegenmaßnahmen, wie etwa die Umbuchung auf alternative Verkehrsträger.

Datenanalyse: Strategisches Warehouse Management (WMS)

Innerhalb der Intralogistik fungiert die Datenanalyse als Gehirn des Lagers. Im Warehouse Management liegt der Fokus auf der maximalen Flächenausnutzung und der Minimierung von Durchlaufzeiten.

Beispiele: Slotting-Optimierung, Bestands- und Nachfrageanalyse

Die Slotting-Optimierung nutzt historische Bestelldaten, um die ideale Platzierung von Waren im Lager zu bestimmen. Artikel, die häufig zusammen bestellt werden oder eine hohe Umschlagshäufigkeit aufweisen (A-Güter), werden an strategisch günstigen Punkten gelagert, um die Laufwege der Kommissionierer zu verkürzen. Durch die Analyse saisonaler Trends lässt sich das Lagerlayout dynamisch anpassen.

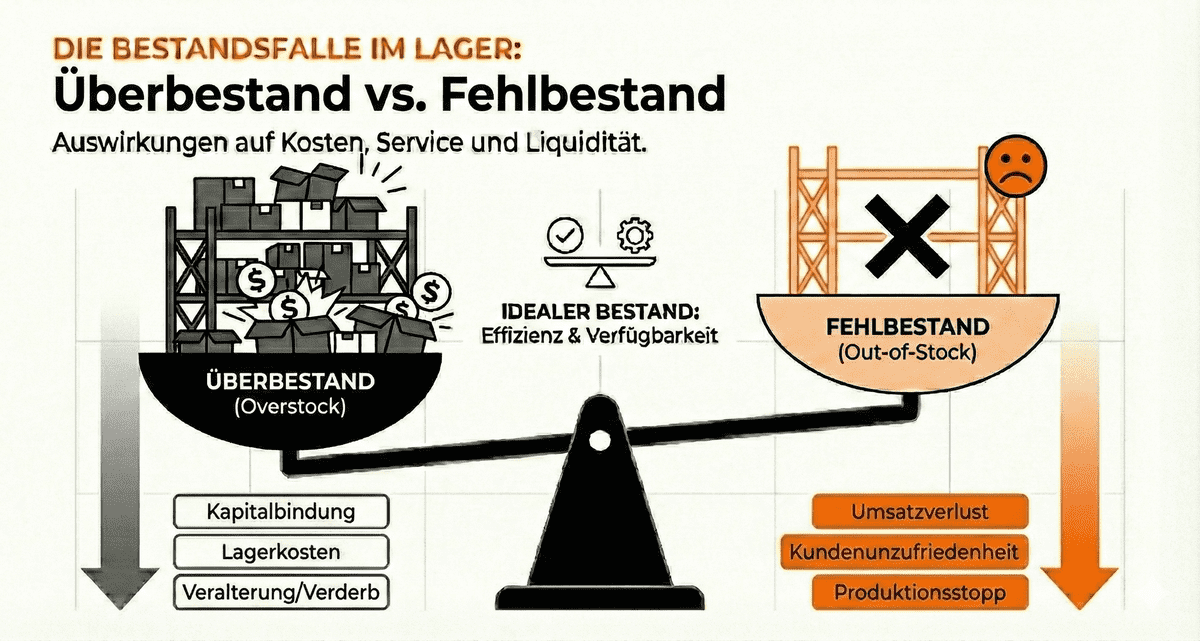

Ein kritischer Bereich ist die Bestands- und Nachfrageanalyse. Überbestände binden Kapital, während Fehlbestände die Lieferfähigkeit gefährden. Prädiktive Modelle analysieren Verkaufszahlen, Markttrends und sogar soziale Faktoren, um den optimalen Sicherheitsbestand zu berechnen.

Grafik: Generiert mit KI

In automatisierten Lagern steuert die Datenanalyse zudem die Interaktion zwischen Mensch und Maschine. Roboter und autonome Transportsysteme (AGV) werden so koordiniert, dass Staus vermieden und die Pick-Raten maximiert werden.

Abschließend dient die Datenanalyse im Lager der operativen Exzellenz. Durch Echtzeit-Monitoring von Prozesszeiten können Engpässe sofort identifiziert werden. Wenn beispielsweise die Verpackungsstation zum Nadelöhr wird, erkennt das System dies sofort anhand der Datenströme und kann eine Umverteilung der Personalressourcen vorschlagen.

Technologische Grundlagen und Zukunft

Die technische Umsetzung moderner Datenanalyse basiert heute auf einer Kombination aus leistungsstarken Datenbanken (z. B. NoSQL oder In-Memory-Datenbanken) und spezialisierten Programmiersprachen wie Python und R. In der Logistik gewinnt zudem das Internet der Dinge (IoT) an Bedeutung, da es die notwendigen Echtzeitdaten direkt von der "Laderampe" oder dem Container liefert.

Die Zukunft der Datenanalyse liegt in der zunehmenden Autonomie. Man spricht hierbei von der Autonomous Supply Chain, in der Systeme nicht nur Analysen erstellen, sondern Handlungen selbstständig ausführen und aus den Ergebnissen lernen.

Trotz aller Automatisierung bleibt der Mensch jedoch die letzte Instanz für die ethische Bewertung und die strategische Einordnung der Ergebnisse, insbesondere wenn es um komplexe globale Risiken geht, die über historische Datenmuster hinausgehen.